L’intelligenza che non c’è. E quella che resta a noi

Da qualche anno viviamo immersi in un paradosso silenzioso: più le macchine producono risultati che sembrano intelligenti, più rischiamo di perdere di vista che l'intelligenza, quella vera, non è mai passata da loro. È passata intorno a loro. È stata riorganizzata, distribuita, incapsulata in procedure che permettono di ottenere esiti sofisticati senza che nessuno, né uomo né macchina, debba realmente comprendere ciò che sta facendo.

Il punto è semplice e insieme destabilizzante: quando osserviamo ciò che l'IA genera, siamo portati a interpretarlo attraverso la lente dell'intelligenza umana. Se un testo è coerente, se un'immagine è credibile, se una mossa a scacchi è brillante, allora — pensiamo — deve esserci un'intelligenza dietro. Ma questa è una proiezione, un riflesso antropomorfico che dice più su di noi che sulle macchine.

L'illusione della comprensione

Le prestazioni dell'IA contemporanea non nascono da comprensione, intenzionalità o pensiero. Nascono dall'incrocio di tre forze che, prese insieme, producono un effetto di profondità senza possederla, in prima istanza una quantità di dati mai viste prima con una potenza di calcolo che supera ogni misura umana e subito dopo modelli statistici capaci di individuare correlazioni su scala massiva. È un'intelligenza senza interiorità, senza mondo, senza esperienza. Una forma di "competenza" che non sa di essere tale, e che non ha bisogno di saperlo per funzionare. La macchina non capisce ciò che fa: esegue e basta. Eppure, proprio perché esegue così bene, ci inganna.

L'esempio degli scacchi è emblematico: il telefono non è intelligente, eppure vince quasi sempre. Non perché abbia intuito, strategia o visione, ma perché opera in un ambiente perfettamente formalizzato, dove ogni possibilità è riducibile a calcolo. La sua forza non è la comprensione del gioco, ma la struttura del gioco stesso.

La vera trasformazione: non macchine più intelligenti, ma processi più meccanizzabili

Il salto degli ultimi anni non è consistito nel trasferire l'intelligenza alle macchine, ma nel ripensare i compiti in modo che l'intelligenza non sia più necessaria. Abbiamo reso automatizzabile ciò che prima richiedeva intuizione, sensibilità, interpretazione. Abbiamo trasformato problemi aperti in problemi chiusi, domande ambigue in input formalizzabili, creatività in combinatoria. È un processo di ingegnerizzazione dell'intelligenza: non si replica la mente, si ricostruisce l'ambiente affinché la mente non serva più.

Perché questa distinzione è cruciale

Non si tratta di sminuire l'IA. Al contrario: riconoscerne la natura reale è l'unico modo per comprenderne davvero la portata. Se continuiamo a chiamarla "intelligente" nel senso umano del termine, rischiamo di attribuirle capacità che non possiede e di delegarle responsabilità che non può assumere.

La domanda non è se l'IA sia intelligente, ma che tipo di intelligenza stiamo sostituendo, e con quali conseguenze. Facciamoci difatti tre domande: Che cosa perdiamo quando un processo viene reso automatico? Che cosa guadagniamo in efficienza, e che cosa rischiamo in comprensione? Quali parti dell'esperienza umana restano irriducibili al calcolo?

Il ruolo che resta all'intelligenza umana

L'intelligenza artificiale eccelle dove il mondo può essere ridotto a pattern, correlazioni, regolarità. L'intelligenza umana eccelle dove il mondo resiste a questa riduzione: nell'ambiguità, nel conflitto, nella contraddizione, nella capacità di attribuire significato. La sfida non è competere con le macchine, ma capire dove la nostra intelligenza è ancora insostituibile, ossia: nella capacità di dare senso, non solo di produrre output; nel giudizio, non solo nella previsione; nella responsabilità, non solo nell'ottimizzazione; nella creatività che nasce dall'esperienza, non dalla combinazione statistica.

L'IA non ci rimpiazza: ci costringe a ridefinire che cosa intendiamo per intelligenza. E forse, paradossalmente, ci invita a tornare a ciò che la rende davvero umana.

A PROPOSITO DI

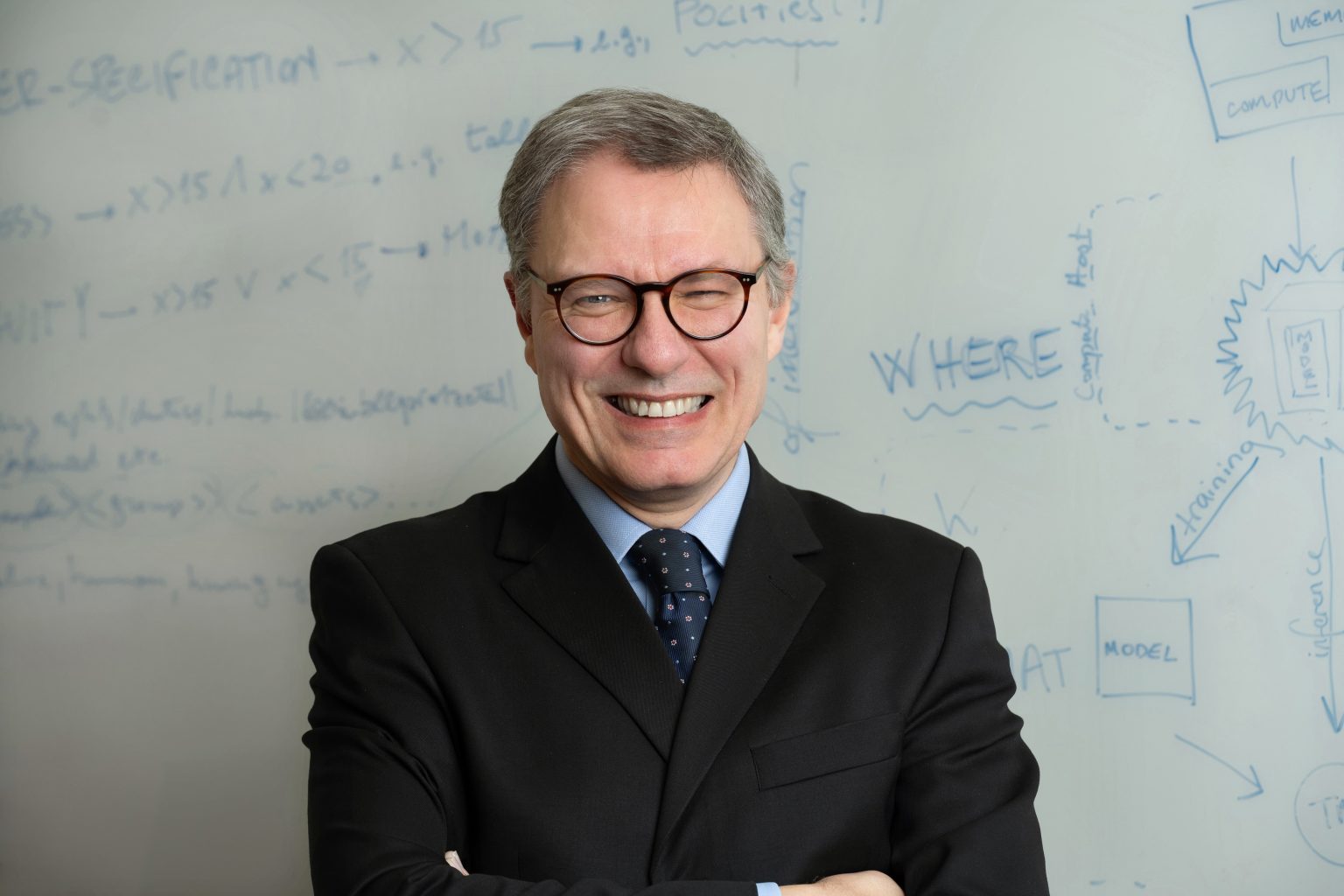

Luciano Floridi e l'IA come "operatività artificiale"

Nel panorama spesso confuso e rumoroso del dibattito sull'intelligenza artificiale, il lavoro di Luciano Floridi rappresenta una delle poche voci capaci di tenere insieme rigore tecnico, profondità filosofica e responsabilità politica. Etica dell'intelligenza artificiale non è un libro da sfogliare distrattamente: è un testo che chiede attenzione, che pretende di essere attraversato con lentezza, perché non si limita a descrivere l'IA — la ricostruisce, la smonta, la ricolloca nel suo contesto storico, epistemologico e sociale.

Floridi parte da un gesto semplice ma decisivo: sottrarre l'IA al mito dell'intelligenza. Non perché voglia ridimensionarne l'importanza, ma perché vuole restituirle la sua natura reale. L'espressione "intelligenza artificiale", ricorda, non è un termine scientifico: non definisce un fenomeno con la precisione di "triangolo" o "mammifero", ma appartiene alla stessa famiglia semantica di parole come "amicizia" o "pornografia", concetti sfumati, elastici, culturalmente negoziati. È un'etichetta che dice più sulle nostre aspettative che sulle capacità delle macchine.

Da qui la sua proposta, radicale nella sua semplicità: chiamarla operatività artificiale. Perché ciò che le macchine fanno non è pensare, comprendere, desiderare, preoccuparsi. È operare — con una potenza, una velocità e una scala che eccedono di gran lunga quelle umane, ma pur sempre senza alcuna forma di interiorità. L'IA, scrive Floridi, non è "più intelligente di un tostapane": è solo infinitamente più capace di correlare dati.

Questa distinzione, che potrebbe sembrare accademica, è in realtà il cuore del problema. Per Luciano Floridi, l'IA non è un tentativo di riprodurre l'intelligenza umana, ma un modo per farne a meno. È la separazione tra comportamento efficace e comportamento intelligente. È la scissione tra la capacità di risolvere problemi e la necessità di comprenderli. È un divorzio, non un matrimonio, tra agire e pensare. Ed è proprio questo divorzio a generare i malintesi più profondi. Perché se l'IA funziona così bene, se produce risultati che sembrano intelligenti, siamo tentati di attribuirle qualità che non possiede. Ma la sua efficacia non deriva da una mente artificiale: deriva da un ambiente che abbiamo progressivamente adattato affinché le macchine possano operare con successo. Le smart cities, ricorda Floridi, non sono città intelligenti: sono città robotizzabili. Habitat progettati per essere compatibili con agenti non intelligenti.

In questo senso, la domanda che Luciano Floridi pone è inquietante nella sua lucidità: è il mondo che si sta adattando all'IA, e non viceversa? Se l'IA è il coniuge "stupido ma laborioso" e l'umanità quello "intelligente ma pigro", chi si adatterà a chi? La metafora è ironica, ma il rischio è reale: diventare parte inconsapevole del meccanismo, come temeva Kant.

In questo senso, la domanda che Luciano Floridi pone è inquietante nella sua lucidità: è il mondo che si sta adattando all'IA, e non viceversa? È un rovesciamento di prospettiva che costringe a guardare oltre la retorica dell'innovazione e a interrogarsi su ciò che davvero sta accadendo sotto la superficie. Perché se l'IA è — come dice Floridi — il coniuge "stupido ma laborioso", e l'umanità quello "intelligente ma pigro", allora la questione non è più soltanto tecnica o filosofica: diventa antropologica. Chi si adatterà a chi? Chi modellerà chi?

La metafora matrimoniale, apparentemente leggera, nasconde una tensione profonda. Da un lato abbiamo un sistema umano che, per sua natura, tende alla comodità, alla delega, alla riduzione dello sforzo cognitivo. Dall'altro una macchina che non comprende, non desidera, non giudica, ma esegue con una costanza e una precisione che nessun organismo biologico può eguagliare. È l'incontro tra due forme di "agire" radicalmente diverse: una orientata al senso, l'altra orientata alla funzione.

Il rischio, allora, non è che l'IA diventi intelligente, ma che noi smettiamo di esserlo nel modo in cui lo siamo sempre stati. Il pericolo non è la ribellione delle macchine, ma la nostra progressiva interiorizzazione delle loro logiche. Diventare parte inconsapevole del meccanismo — come temeva Kant — significa accettare senza accorgercene che il mondo venga ristrutturato secondo criteri di efficienza, ottimizzazione, prevedibilità, riducendo lo spazio dell'ambiguità, del conflitto, dell'imprevedibile: cioè proprio ciò in cui l'intelligenza umana trova il suo terreno naturale. Quando Floridi osserva che stiamo progettando ambienti compatibili con i robot, non sta facendo un'iperbole. Sta descrivendo un processo già in atto: città che si "smartizzano" non per diventare più intelligenti, ma per diventare più leggibili dalle macchine; procedure amministrative che si digitalizzano non per semplificare la vita ai cittadini, ma per essere processabili da sistemi automatizzati; interazioni sociali che si appiattiscono in formati standardizzati, perché solo ciò che è standardizzabile può essere automatizzato.

In questo scenario, l'adattamento non è un evento improvviso, ma un lento slittamento. Non ci sveglieremo un giorno scoprendo di essere diventati ingranaggi: lo saremo diventati gradualmente, ogni volta che avremo accettato una piccola rinuncia alla complessità in nome della comodità, ogni volta che avremo preferito un algoritmo al giudizio, una procedura alla responsabilità, una correlazione alla comprensione. La domanda di Floridi, dunque, non è retorica. È una soglia critica: ci chiede di riconoscere che la sfida dell'IA non è competere con le macchine, ma evitare di diventare compatibili con esse. Non è difendere l'intelligenza umana come un monumento del passato, ma preservare la sua capacità di resistere alla riduzione, di abitare l'ambiguità, di generare senso dove la macchina vede solo dati.

Tornando al libro, esso affronta poi il nodo più delicato: gli algoritmi. Non tanto nella loro definizione tecnica, quanto nelle loro implicazioni etiche e politiche. Gli algoritmi non sono neutri, ricorda Floridi. Portano con sé i pregiudizi dei dati su cui sono addestrati, le intenzioni di chi li progetta, le distorsioni di chi li utilizza. Il deep learning, con la sua fame insaziabile di dati, amplifica questi rischi: se la qualità e la provenienza dei dati sono compromesse, lo saranno anche le decisioni che ne derivano.

Per questo Floridi insiste su un'etica dell'IA che non sia un esercizio retorico, ma un quadro operativo. Propone cinque principi: i quattro classici della bioetica — beneficenza, non maleficenza, autonomia, giustizia — più un quinto, specifico per il digitale: l'esplicabilità. Ovvero la trasparenza, la responsabilità, la possibilità di comprendere come e perché un sistema prende una decisione. Senza questo principio, l'IA rischia di diventare una tecnologia opaca, incontrollabile, potenzialmente dannosa.

Il libro non si limita a denunciare i rischi: propone un modello di governance. Un "design partecipativo", un patto sociale mediato dalle macchine, in cui programmatori, produttori, utilizzatori e committenti condividano responsabilità e limiti. Per Floridi, l'IA non è una tecnologia da regolamentare dopo: è una tecnologia da progettare con la regolazione incorporata. L'errore commesso con il Web — lasciarlo crescere senza un quadro etico — non può essere ripetuto.

Infine, Luciano Floridi allarga lo sguardo alla dimensione antropologica. L'IA non è solo una tecnologia: è un cambiamento nel modo in cui concepiamo la realtà. Stiamo accettando il virtuale come parzialmente reale e il reale come parzialmente virtuale. È una trasformazione profonda, che tocca la nostra percezione, la nostra identità, la nostra relazione con il mondo. Una rivoluzione silenziosa, più radicale di quanto molti siano disposti ad ammettere.

In questo senso, il libro di Luciano Floridi si integra perfettamente con la riflessione sull'"intelligenza che non c'è". Perché mostra, con rigore e chiarezza, che ciò che chiamiamo intelligenza artificiale è in realtà un nuovo modo di organizzare l'azione, non il pensiero. Un nuovo modo di distribuire il potere, non la comprensione. Un nuovo modo di costruire ambienti compatibili con agenti non intelligenti, e di adattare noi stessi a questi ambienti.

È un testo che non offre risposte semplici, ma strumenti per pensare. E oggi, in un'epoca in cui l'IA rischia di essere travolta da entusiasmi ingenui o paure apocalittiche, questo è forse il contributo più prezioso.

Viviamo in un tempo in cui la comunicazione non è più un servizio: è un ecosistema. Un territorio instabile, attraversato da estetiche che mutano con la velocità dei flussi digitali, da algoritmi che riscrivono la percezione, da pubblici che oscillano tra saturazione e desiderio. In questo paesaggio, la differenza non la fa chi produce contenuti,...

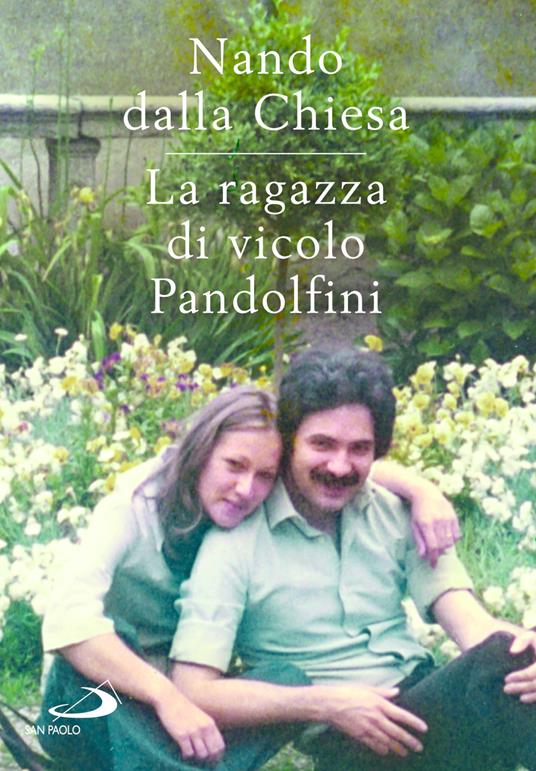

Ci sono libri che si sfogliano con leggerezza, e altri che si affrontano come si affronta un dolore antico: con rispetto, con cautela, con quella sorta di tremore che accompagna ogni gesto quando si teme di toccare qualcosa di troppo fragile. La ragazza di vicolo Pandolfini appartiene a questa seconda categoria. Non è un romanzo, non è un...

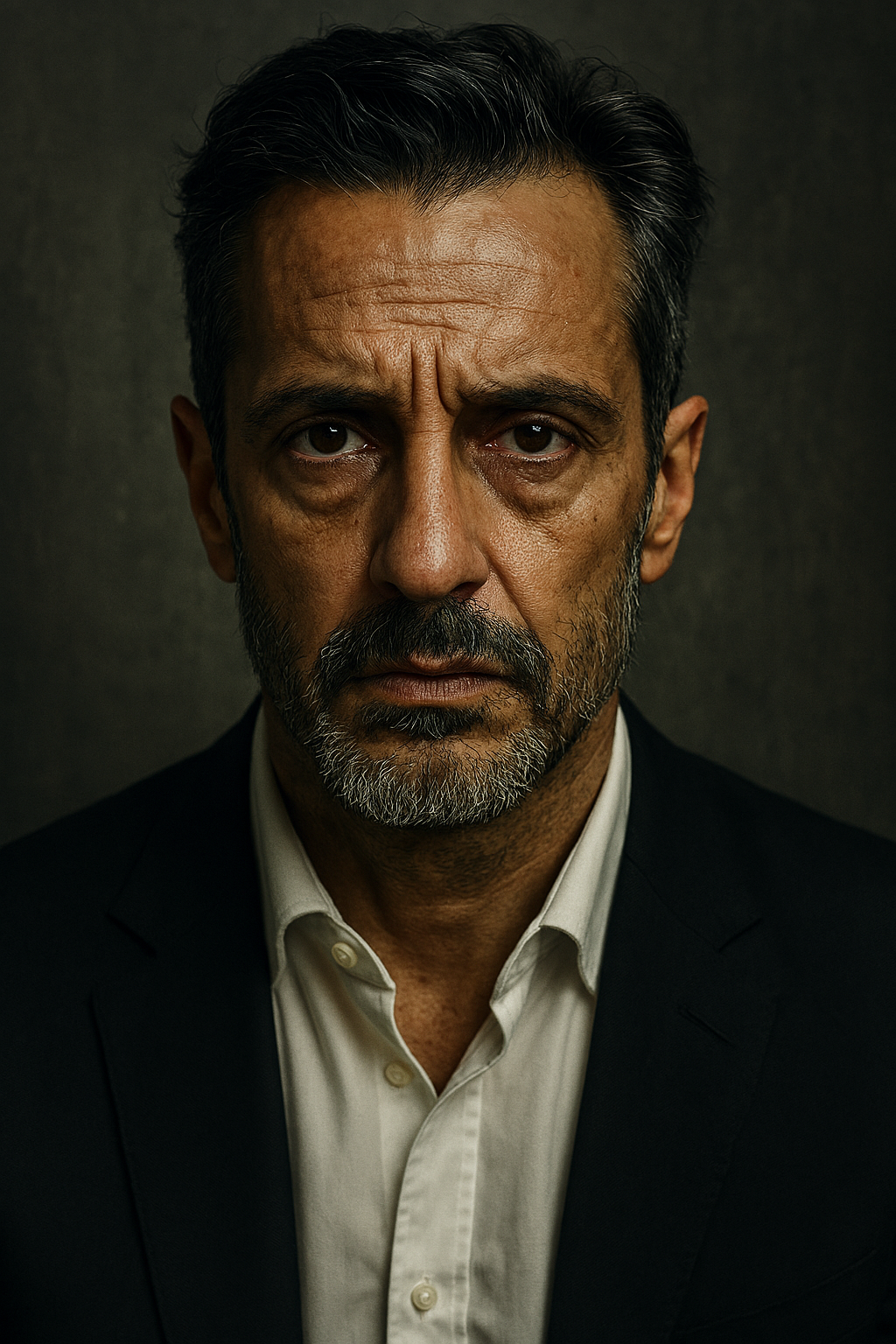

Nel panorama contemporaneo dell'immagine, dove l'intelligenza artificiale sembra spesso ridurre la figura dell'autore a un'ombra, l'opera di Caspar Jade si impone come un controcanto necessario. Non un fotografo che "usa l'AI", ma un autore che trasforma l'AI in un'estensione della propria sensibilità, un dispositivo capace di amplificare la sua...